Digitale Barrierefreiheit, Apple präsentiert neue Funktionen für 2025

Der 15. Mai ist der Global Accessibility Awareness Day, ein internationaler Tag, der jedes Jahr in diesem Monat gefeiert wird, um das Bewusstsein für das Thema digitale Barrierefreiheit zu schärfen. Apple hat die Abteilung, die sich mit der Entwicklung dieser Lösungen befasst, vor 40 Jahren gegründet. Ein Weg, der der Entwicklung von Technologie und Geräten folgte: die Einführung von Voice-Over auf dem iPhone im Jahr 2009, die „MFi-Hörgeräte“. „Made for iPhone-Hörgeräte“ – das heißt Hörgeräte, die 2014 mit dem iPhone kompatibel waren, „Accessibility Reader“-Modus, um Benutzern mit Seh- oder kognitiven Behinderungen im letzten Jahr das Lesen zu erleichtern, und so weiter.

Für 2025 wurden eine Reihe neuer Funktionen eingeführt, die später in diesem Jahr erscheinen, angefangen mit Barrierefreiheitskarten im App Store, dann Lens für Mac, Braille Access und Accessibility Reader und mehr. Im Mai werden in ausgewählten Apple Stores spezielle Tische aufgestellt, auf denen die Bedienungshilfen verschiedener Geräte vorgestellt werden. Zusätzlich zu den Today at Apple-Sitzungen, die das ganze Jahr über diesem Thema gewidmet sind.

„Barrierefreiheit ist Teil der DNA von Apple“, sagte Tim Cook, CEO von Apple. „Die Entwicklung von Technologien, die allen Menschen zugutekommen, hat für uns Priorität, und wir freuen uns über die Innovationen, die wir in diesem Jahr vorstellen. Wir bieten Tools an, die Menschen helfen, auf wichtige Informationen zuzugreifen, die Welt um sie herum zu erkunden und all das zu tun, was sie lieben.“

„Bei Apple blicken wir auf eine 40-jährige Geschichte der Innovation im Bereich der Barrierefreiheit zurück und wir sind entschlossen, auch weiterhin die Grenzen zu erweitern, indem wir in allen unseren Produkten neue Funktionen zur Barrierefreiheit einführen“, sagt Sarah Herrlinger, Senior Director of Global Accessibility Policy and Initiatives bei Apple. „Diese Funktionen nutzen die Leistungsfähigkeit des Apple-Ökosystems und arbeiten nahtlos zusammen, um den Menschen neue Möglichkeiten zur Interaktion mit den Dingen zu bieten, die ihnen am wichtigsten sind.“

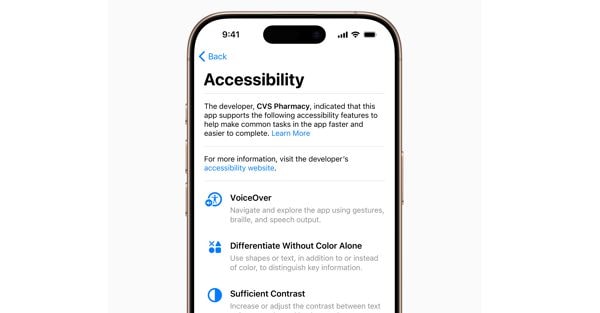

Mit Accessibility Cards wird auf den Produktseiten des App Store ein neuer Abschnitt eingeführt, der die Barrierefreiheitsfunktionen in Apps und Spielen hervorhebt. Mithilfe dieser Karten können Benutzer vor dem Herunterladen einer App feststellen, ob diese barrierefrei ist. Entwickler haben so die Möglichkeit, die Benutzer besser zu informieren und ihnen zu erklären, welche Funktionen ihre App unterstützt. Dazu gehören VoiceOver, Sprachsteuerung, größerer Text, guter Kontrast, Bewegungsreduzierung, Transkriptionen und mehr.

Barrierefreiheitskarten für Apps

Seit 2016 bietet die Magnifier-App auf iPhone und iPad blinden oder sehbehinderten Menschen Werkzeuge zum Vergrößern, Lesen von Text und Erkennen von Objekten in ihrer Umgebung. Dieses Jahr kommt die Lens-App auf den Mac, um Menschen mit Sehschwäche die reale Welt zugänglicher zu machen. Die Lens-App für Mac stellt eine Verbindung zu Ihrer Kamera her und ermöglicht Ihnen, alles um Sie herum zu vergrößern, beispielsweise einen Bildschirm oder ein Whiteboard. Lens funktioniert mit der Continuity-Kamera auf dem iPhone und angeschlossenen USB-Kameras und unterstützt das Lesen von Dokumenten mithilfe der Desktop-Übersicht.

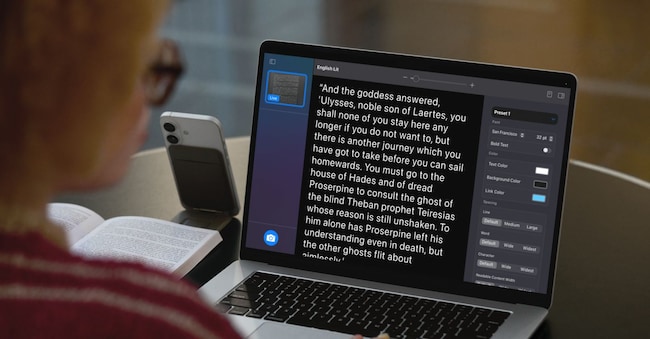

Mit mehreren Live-Sitzungsfenstern können Benutzer mehrere Aufgaben gleichzeitig erledigen, indem sie eine Präsentation mit einer Webcam ansehen und gleichzeitig mit der Desktop-Übersicht ein Buch lesen. Mit benutzerdefinierten Ansichten können Sie Helligkeit, Kontrast, Farbfilter und sogar die Perspektive anpassen, um Text und Bilder leichter lesbar zu machen. Sie können außerdem Ansichten erfassen, gruppieren und speichern, um später daran zu arbeiten. Darüber hinaus integriert die Lens-App für Mac eine weitere neue Eingabehilfefunktion, den Accessibility Reader, der in der realen Welt erkannten Text in ein benutzerdefiniertes, lesbares Format umwandelt.

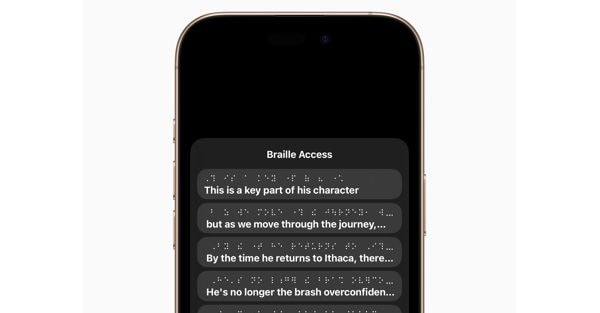

Braille-Lesen

Braille Access verwandelt iPhone, iPad, Mac und Apple Vision Pro in komplette Tools zum Notieren in Braille, dem taktilen Lese- und Schreibsystem, das hauptsächlich von blinden oder sehbehinderten Menschen verwendet wird. Mit einem integrierten App-Launcher können Benutzer jede App einfach öffnen, indem sie mit „Screen Braille Input“ oder einem angeschlossenen Braille-Gerät tippen. Mit Braille Access können Sie im Handumdrehen Notizen in Braille machen und Berechnungen mit dem Nemeth-Braille-Code durchführen, der häufig im naturwissenschaftlichen und mathematischen Unterricht verwendet wird. Benutzer können Braille Ready Format (BRF)-Dateien direkt von „Braille Access“ aus öffnen und so auf eine große Auswahl an Büchern und Dateien zugreifen, die zuvor auf Geräten erstellt wurden, die das Erstellen von Braille-Notizen unterstützen. Und dank einer integrierten Version von „Live Transcriptions“ können sie Gespräche in Echtzeit direkt auf Braille-Displays transkribieren.

Accessibility Reader ist ein neuer, systemweiter Lesemodus, der Benutzern mit verschiedenen Behinderungen wie Legasthenie oder Sehschwäche das Lesen von Texten erleichtern soll. Der Accessibility Reader ist für iPhone, iPad, Mac und Apple Vision Pro verfügbar und bietet Benutzern neue Möglichkeiten, Text anzupassen und sich auf den Inhalt zu konzentrieren, den sie lesen möchten. Er bietet mehrere Optionen für Schriftart, Farbe und Abstand sowie Unterstützung für „Inhalt vorlesen“. Accessibility Reader kann von jeder App aus gestartet werden und ist in die Lens-App für iOS, iPadOS und macOS integriert, sodass Benutzer mit realem Text, beispielsweise Büchern oder Restaurantmenüs, interagieren können.

Die für gehörlose oder schwerhörige Menschen entwickelten Live-Mithör-Steuerelemente kommen mit einer Reihe neuer Funktionen auf die Apple Watch, darunter Live-Transkriptionen in Echtzeit. „Live Listen“ verwandelt das iPhone in ein Fernmikrofon, um Inhalte direkt auf AirPods, Beats-Kopfhörer oder Made for iPhone-Hörgeräte zu streamen. Wenn eine Sitzung auf dem iPhone aktiv ist, können Benutzer „Live-Transkripte“ der vom iPhone erkannten Inhalte auf einer gekoppelten Apple Watch anzeigen, während sie den Ton anhören. Die Apple Watch fungiert als Fernbedienung zum Starten oder Stoppen von Live-Mithörsitzungen oder zum Zurückkehren zu einer Sitzung, um alles nachzuholen, was Sie möglicherweise verpasst haben. Mit der Apple Watch können Benutzer Live-Listen-Sitzungen vom anderen Ende des Raums aus steuern, ohne mitten in einer Besprechung oder Vorlesung aufstehen zu müssen.

Für blinde oder sehbehinderte Menschen erweitert visionOS die Sehhilfefunktionen mithilfe des fortschrittlichen Kamerasystems in Apple Vision Pro. Dank der leistungsstarken Updates für Zoom können Benutzer mit der Hauptkamera alles in ihrem Sichtfeld vergrößern, einschließlich ihrer Umgebung. Für diejenigen, die VoiceOver verwenden, nutzt die Echtzeiterkennung in visionOS maschinelles Lernen auf dem Gerät, um Ihre Umgebung zu beschreiben, Objekte zu finden, Dokumente zu lesen und mehr.

Neuigkeiten und Einblicke in politische, wirtschaftliche und finanzielle Ereignisse.

Melden Sie sich anilsole24ore