OpenAi bringt zwei Open-Weight-Modelle auf den Markt und erobert damit den Bereich von DeepSeek und Llama

Als DeepSeek, das offene chinesische KI-Modell, das die Wall Street erschütterte, auf den Markt kam, twitterte Sam Altman, die Wahl von ChatGpt als geschlossenes System sei möglicherweise ein Fehler gewesen. Einige Monate später fiel die Entscheidung, zwei Modelle namens gpt-oss-120B und gpt-oss-20B auf den Markt zu bringen. Dabei handelt es sich um offene, gewichtete Reasoning-Modelle, die laut OpenAi die fortschrittlichsten ihrer Art sind. Sie können kostenlos heruntergeladen, trainiert und direkt mit den Hardwareressourcen eines Standard-Laptops genutzt werden. Es handelt sich nicht um ChatGpt 5, das wahrscheinlich bald veröffentlicht wird, sondern um ein KI-Modell, dessen Gewichte (d. h. die während des Trainings erlernten Parameter) im Gegensatz zu ChatGpt, Gemini und Microsoft Copilot öffentlich verfügbar sind. Ein weiteres Merkmal ist, dass es sich um ein „Reasoning-Modell“ handelt und daher, vereinfacht gesagt, „nachdenkt, bevor es reagiert“. Der Vorteil: Es bietet hohe Leistung in der Praxis zu geringen Kosten. Die Herausforderung besteht darin, mit Lllama in das Feld von Meta, mit Gemma in das Feld von Google und mit Deepseek und Qwen in das Feld der Chinesen einzudringen.

Wie auf der Website angegeben, sind diese Modelle unter der flexiblen Apache 2.0-Lizenz verfügbar. Sie sollen ähnlich große offene Modelle bei Reasoning-Aufgaben übertreffen, verfügen über starke Tool-Nutzungsfähigkeiten und sind für den effizienten Einsatz auf Consumer-Hardware optimiert. Sie wurden mit einer Mischung aus Reinforcement Learning und Techniken trainiert, die auf den fortschrittlichsten internen Modellen von OpenAI basieren, darunter o3 und andere Spitzensysteme.

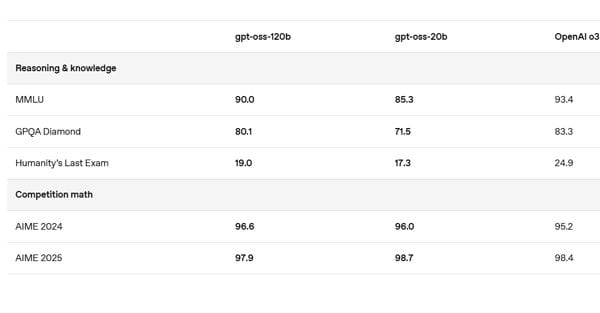

Das Modell gpt-oss-120b erreicht in Benchmarks für grundlegendes Denken nahezu die gleiche Leistung wie OpenAI o4-mini und läuft dabei effizient auf einer einzelnen 80-GB-GPU. Das Modell gpt-oss-20b liefert in gängigen Benchmarks ähnliche Ergebnisse wie OpenAI o3-mini und kann auf Edge-Geräten mit nur 16 GB Speicher ausgeführt werden. Insbesondere letzteres scheint für den Betrieb auch mit begrenzten Hardwareressourcen ausgelegt zu sein, sodass es theoretisch auch offline genutzt werden kann. Dies reduziert die Hürden für Entwickler, Start-ups und Organisationen in Schwellenländern oder Hochsicherheitsumgebungen und ermöglicht ihnen, KI auf ihrer eigenen Infrastruktur auszuführen und anzupassen.

OpenAI veröffentlicht neue Entwicklerhandbücher und Tools, die Teams dabei helfen, verantwortungsvoll Feinabstimmungen vorzunehmen, Leitplanken zu implementieren und Modelle mit Hugging Face, vLLM, Ollama, llama.cpp und wichtigen GPU-/Beschleunigerplattformen zu integrieren.

Die Open-Weight-Modelle werden auf Hugging Face und anderen Plattformen geteilt. Der technische Bericht, das Sicherheitsdokument, das Systemblatt und die Entwicklerhandbücher werden später heute verfügbar sein.

ilsole24ore